Новая версия фотоперевода от «Яндекса» поможет читать тексты с картинок на десятках языков

«Яндекс» представил новую версию технологии перевода текста на изображениях. Она работает на базе нейросетей и позволяет переводить картинки с учётом контекста. Например, в поездке можно быстро перевести меню в ресторане, а на работе — разобраться в технической документации.

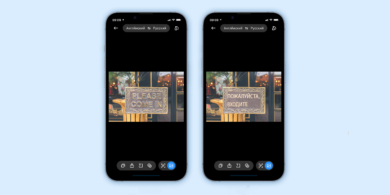

Также «Яндекс» улучшил визуализацию перевода — текст стал легче читаться и больше похож на оригинальную вёрстку. Нейросети понимают стиль оригинального контента и умеют сохранять игру слов. Также они подбирают более точные формулировки во фразах с несколькими значениями. Выросло качества перевода не только простых текстов, но сложных публицистических статей и инструкций.

Также разработчики улучшили визуализацию для нескольких десятков языков. Технология стирает с картинки оригинальный текст и показывает вместо него перевод. Алгоритмы подбирают наиболее подходящие шрифт, размер и цвет букв, а также убирают различные артефакты. Во многих случаях текст получается более контрастным, поэтому читать его даже легче, чем оригинал.

Для перевода текста на изображениях «Яндекс» создал отдельную модель YandexGPT. Её обучили на множестве пар оригинальных и переведённых текстов. Модели показывали примеры качественных и плохих переводов, чтобы она училась подражать эталонным, избегала ошибок и не добавляла несуществующие детали.

Обновление уже доступно в «Яндекс Переводчике» и «Яндекс Браузере», а позже появится и в «Умной камере» в приложении «Яндекс».

Станьте первым, кто оставит комментарий